(DeepFake | جعل عمیق) بحث داغ این روزای دنیای تکنولوژی است.سیستمهای دیپ فیک (جعل عمیق) مبتنی بر (Deep Learning|یادگیری عمیق) و( Machine Learning|یادگیری ماشین) کار میکنند. دیپ فیک شاید تکنولوژی سرگرم کننده به نظر برسد .اما این تکنولوژی برای جابه جایی چهره افراد و تحریف کردن(Doctoring) ویدیو ها مورد استفاده قرار میگیرد. دیپ فیک تکنولوژی هوشمند در عین حال خطرناک است.قابلیت گول زدن افراد با محتویات جعلی توسط دیپ فیک به جرات میتوان گفت یکی از ترسناک ترین سناریوهای هوش مصنوعی است.البته تمامی تکنولوژی ها قابلیت این را دارند برای مقاصد خصمانه یا مفید مورد استفاده بگیرند. دیپ فیک علاوه بر قابلیت های خصمانه پتانسیل این را دارد که در کارهای مفیدی از جمله تجارت مورد استفاده قرار بگیرد.

معرفی دیپ فیک

اصطلاح دیپ فیک به ویدئوها و صداهای جعلی و تولید شده به وسیله کامپیوتر اطلاق میشود.که تشخیص آنها از محتویات واقعی (Genuine) و بدون تغییر (Unaltered) بسیار سخت است. دیپ فیک جهت تغییر فایلهای ویدئویی، معادل نرمافزار فتوشاپ برای تصاویر دیجیتالی محسوب میشوند.

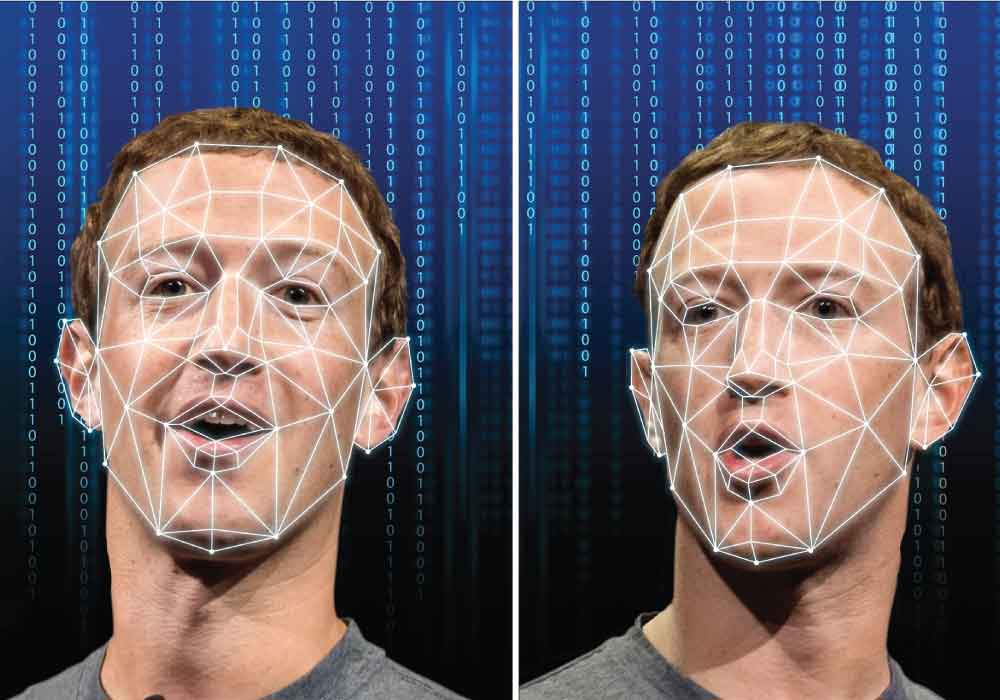

در سیستمهای دیپ فیک یا جعل عمیق، معمولا از دسته خاصی از الگوریتمهای یادگیری ماشین به نام شبکههای مولد تخاصمی» (Generative Adversarial Networks) جهت «ترکیب کردن» (Combine) و «برهمنهی» (Superimpose) تصاویر و ویدئوهای موجود، روی مجموعهای از تصاویر یا ویدئوهای «منبع» (Source) استفاده میشود.

ویدیو زیر نمونه ای بارز از دیپ فیک است . بر روی چهره رامی ملک بازیگر مشهور سریال مستر ربات پیاده شده است.اگرچه این ویدئو نسبت به دیگر نمونههای دیپفیک از کیفیت پایینتری برخوردار است. اما قطعاً با پیشرفت این فناوری میتوان آیندهای را متصور شد که هرکس طبق علایق خود، بازیگر موردنظرش را برای صحنههای مختلف فیلم درنظر بگیرد.

محتوای دیپ فیک چگونه ساخته میشود؟

ویدئوهای دیپ فیک (جعل عمیق)، با استفاده از دو سیستم یا مدل هوش مصنوعی «رقابت کننده» (Competing) پدید میآیند. دسته اول از چنین مدلها یا سیستمهای هوش مصنوعی رقابت کننده، سیستمهای «مولد» (Generator) نام دارد. دسته دوم، سیستمهای «متمایزگر یا تمایزی» (Discriminator).

روش کار سیستمهای هوشمند تولید کننده محتوای دیپ فیک بدین صورت است که ابتدا مدلهای مولد (Generator)، یک ویدئوی جعلی تولید میکند. سپس، ویدئوی تولید شده به عنوان ورودی مدلهای متمایزگر وارد سیستم میشود. وظیفه مدل متمایزگر این است که تشخیص دهد آیا ویدئوی تولید شده واقعی است یا جعلی.

هر بار که مدل متمایزگر بتواند به درستی، جعلی بودن ویدئوها را تشخیص دهد، باز خورد یا سیگنالی در اختیار مدل مولد قرار میدهد. این سیگنال یا بازخورد، خطاهای مدل مولد در تولید ویدئوهای تقلبی را مشخص میکند. مدل مولد بر اساس «بازخوردهای» (Feedbacks) ایجاد شده، اقدام به تصحیح خطا و تولید ویدئوهای تقلبی جدید میکند.

از در کنار هم قرار گرفتن مدلهای مولد و متمایزگر، شبکههای مولد تخاصمی شکل خواهد گرفت. اولین قدم در پیادهسازی یک مدل شبکههای مولد تخاصمی یا GAN، شناسایی خروجی مطلوب و تولید یک مجموعه داده آموزشی برای مدل مولد است. به محض اینکه عملکرد و دقت مدل مولد در تولید ویدئوهای جعلی به سطح مطلوبی برسد. ویدئوهای تولید شده به عنوان ورودی مدل متمایزگر عمل خواهند کرد.

همانطور که به مرور زمان عملکرد مدل مولد در تولید ویدئوهای جعلی افزایش پیدا میکند، مدل متمایزگر نیز دقت بیشتری در تشخیص ویدئوهای جعلی از خود نشان میدهد. همچنین، با افزایش دقت و عملکرد مدل متمایزگر در تشخیص ویدئوهای جعلی، دقت مدل مولد در تولید ویدئوهای جعلی با کیفیت و نزدیک به واقعیت افزایش پیدا میکند.

کاربردهای دیپ فیک

تولید محتوای ویدئویی

شاید یکی از فناوریهای مشابهی که پیش از این در صنعت فیلم مورد استفاده شده است، فناوری تولید محتوای ویدئویی با استفاده از «جلوههای ویژه» باشد. اگرچه این فناوری (تولید چهرههای کامپیوتری و جا به جا کردن آنها با چهره بازیگران) سالهای زیادی است که در صنعت فیلم استفاده میشود. با این حال، سادگی دسترسی دیپ فیک و هزینه به مراتب کمتر آنها نسبت به جلوههای ویژه پرهزینه، دیپ فیک را به یک انتخاب وسوسهبرانگیز و هیجانآور برای افراد مختلف، به ویژه آماتورهای علاقهمند به این حوزه تبدیل کرده است.

البته، نمیتوان منکر استفادههای متعدد این فناوری در صنعت فیلم شد. به عنوان نمونه، این قابلیت برای شرکتهای سازنده فیلمهای سینمایی وجود دارد که فیلمها را با بازیگران ناشناخته ضبط کنند . سپس، در مرحله ویرایش، تصاویر بازیگران معروف روی تصاویر ضبط شده قرار داده شود. سناریوی حقیقی دیگر جهت استفاده از فناوری دیپ فیک، تغییر بازیگر فیلم بر اساس بازار فروش و یا امکان انتخاب بازیگر توسط کاربر است. بدین صورت که با استفاده از این فناوری، این امکان برای کاربران فراهم میشود تا پیش از پخش یک فیلم، بازیگر مورد علاقه خود را برای ایفای نقش انتخاب کنند.

استفاده از چهره افراد مشهور برای تبلیغات پوشاک

در این سناریو، افراد مشهور چهرههای مدل شده و کامپیوتری خود را به شرکتهای تولید پوشاک قرض میدهند تا این شرکتها بدون نیاز به فیلمبرداری کلیپهای تبلیغاتی، از چهره آنها برای تبلیغ پوشاک و وسایل جانبی استفاده کنند (قرار دادن چهره افراد معروف روی مانکنهای لباس).

ساخت انسانهای مجازی

انسانهای مجازی دستاورد مهم دیگری در حوزهی تعاملات کاربر دنیای فناوری هستند. آنها با روشی متفاوت از دستیارهای شخصی به سمت بدنهی جامعه حرکت میکنند. مسیر آنها از سمت اینفلوئنسرهای دیجیتال دنبال میشود؛ اینلفوئنسرهایی که در دستهی انسانهای مجازی قابل باور قرار میگیرند. آنها نوعی از ارتباط را ایجاد میکنند که به رفتارهای انسانی عموم جامعه نزدیکتر است.

بهعنوان نمونهای از اینفلوئنسرهای دیجیتال میتوان به Lil Miquela یا Astro در اینستاگرام اشاره کرد .آنها ارتباطی طبیعی و نزدیک با کاربران دارند. البته پاسخ آنها به کاربران و تعاملهای مربوطه، توسط افراد دیگر و انسانهای واقعی نوشته میشود. اما رویکردهای موجود نشان از آیندهای دارند که انسانهای مجازی به پدیدهای رایج در شبکههای مجازی تبدیل شوند.

دیپ فیک و زیرپا گذاشتن اخلاقیات

متأسفانه دیپفیک تنها به یک یا دو حوزهی خاص خلاصه نمیشود . آثار مخرب این فناوری را میتوان در جنبههای مختلف زندگی مشاهده کرد.

یکی از بحثبرانگیزترین و غیراخلاقیترین زمینههای فعالیت دیپفیک، تولید محتوای ویدئویی بزرگسالانه است. سال ۲۰۱۷ میلادی، کاربری در وبسایت ردیت؛ ویدئویی غیراخلاقی و دروغین از بازیگری با نام Gal Gadot منتشر کرد . که وی را درحال ایفای نقش در فیلمهای غیراخلاقی نشان میداد. اگرچه این ویدئو توسط فناوری دیپفیک ساخته شده بود. اما نوع مونتاژ بهگونهای بود که در نگاه نخست کمتر کسی میتوانست متوجه جعلیبودن ویدئو شود.

طولی نکشید که اتفاقات مشابه با همین مضمون برای دیگر بازیگران مطرحِ سینما رخ داد. بدینگونه، افرادی که در ابتداییترین جنبههای زندگی روزمره خود جانب احتیاط را پیشه میکنند. خود را در ویدئوهایی دیدند که پیشتر تصور آن نیز از ذهنها دور بود.

محدودیتهای سیستمهای تولید دیپ فیک

با وجود اینکه نتایج حاصل از تولید ویدئوهای دیپ فیک ممکن است برای کاربران جذاب باشد. اما، استفاده از فناوریهای هوش مصنوعی و دیپ لرنینگ جهت تولید ویدئوهای دیپ فیک محدودیتهایی نیز دارند که در ادامه به آنها میپردازیم.

سیستم تنها در صورتی قادر به تولید ویدئوهای دیپ فیک مطلوب خواهد بود که مجموعه بزرگی از تصاویر را برای آموزش در اختیار داشته باشد. برای اینکه سیستم قادر باشد تصویر یک شخص خاص را روی یک ویدئوی خاص قرار دهد، لازم است چیزی حدود 300 الی 2000 تصویر از صورت شخص در اختیار سیستم قرار داده شود تا شبکه عصبی قادر به یادگیری و بازسازی چهره آن شخص و قرار دادن آن روی ویدئوی مورد نظر باشد.

دادههای آموزشی استفاده شده برای پیادهسازی سیستمهای دیپ فیک، باید به خوبی نمایانگر ویژگیهای ویدئوی هدف باشد. فرض کنید که قرار باشد چهره شخص A روی چهره شخص B در یک ویدئوی خاص قرار بگیرد. در چنین حالتی، تصاویر آموزشی شخص A باید در زوایا و حالات مختلف در اختیار سیستم قرار بگیرد تا سیستم بتواند به درستی ویژگیهای چهره این شخص را یاد بگیرد.

ساختن مدلهای تولید دیپ فیک (جعل عمیق)، هزینه زمانی و محاسباتی زیادی میطلبد. سیستمهای تولید دیپ فیک از ماژولهای مختلفی نظیر «تشخیص چهره» (Face Detection) و همترازی تصاویر تشکیل شدهاند. هر کدام از این ماژولها، قدرت محاسباتی قابل توجهی را به خود اختصاص خواهند داد.مثلا آموزش یک مدل یادگیری عمیق برای تولید دیپ فیک با کیفیت معمولی، چیزی حدود 72 ساعت زمان خواهد برد. برای آموزش چنین سیستمی، به قدرت محاسباتی بسیار زیادی نیاز است. از سوی دیگر، هر مدل دیپ فیک تولید شده، تنها قادر به قرار دادن تصویر یک شخص خاص روی ویدئو خواهد بود . برای قرار دادن تصویر یک شخص دیگر روی ویدئو، احتیاج به آموزش یک مدل دیگر خواهد بود. به عبارت دیگر، سیستمهای تولید دیپ فیک، مقیاسپذیری خوبی از خود نشان نمیدهند.

و حرف آخر…

فناوریهای دیپ فیک (جعل عمیق)، یکی از جنجالبرانگیزترین فناوریهایی است که در چند سال اخیر معرفی شده است .طی این مدت کوتاه توانسته است بخشهای مختلفی از جامعه انسانی و حتی مسائل سیاسی را نیز تحت تأثیر خود قرار دهد. چنین کاربردی از فناوری ممکن است یک هاله ابهام در مورد صحت و اعتبار ویدئوهای منتشر شده در سطح وب ایجاد کند.

با این حال، ظهور دیپ فیک، جذاب بودن این فناوری و کاربردهای گسترده (و مفید) آن در حوزههای مختلف علم و فناوری را نشان داد. امروز همه میدانیم که استفادهی سوء از دیپ فیک، چالشهایی را برای جامعه بههمراه خواهد داشت. بهعلاوه با افزایش آگاهی از زمینههای سوءاستفاده، پیشگیری از عواقب آنها نیز آسانتر خواهد بود. البته درنهایت این فناوری توسعه یافته است و در دنیای آیندهی ما حضور جدی خواهد داشت.